HadoopSpark集群部署手册Word格式文档下载.docx

《HadoopSpark集群部署手册Word格式文档下载.docx》由会员分享,可在线阅读,更多相关《HadoopSpark集群部署手册Word格式文档下载.docx(23页珍藏版)》请在冰点文库上搜索。

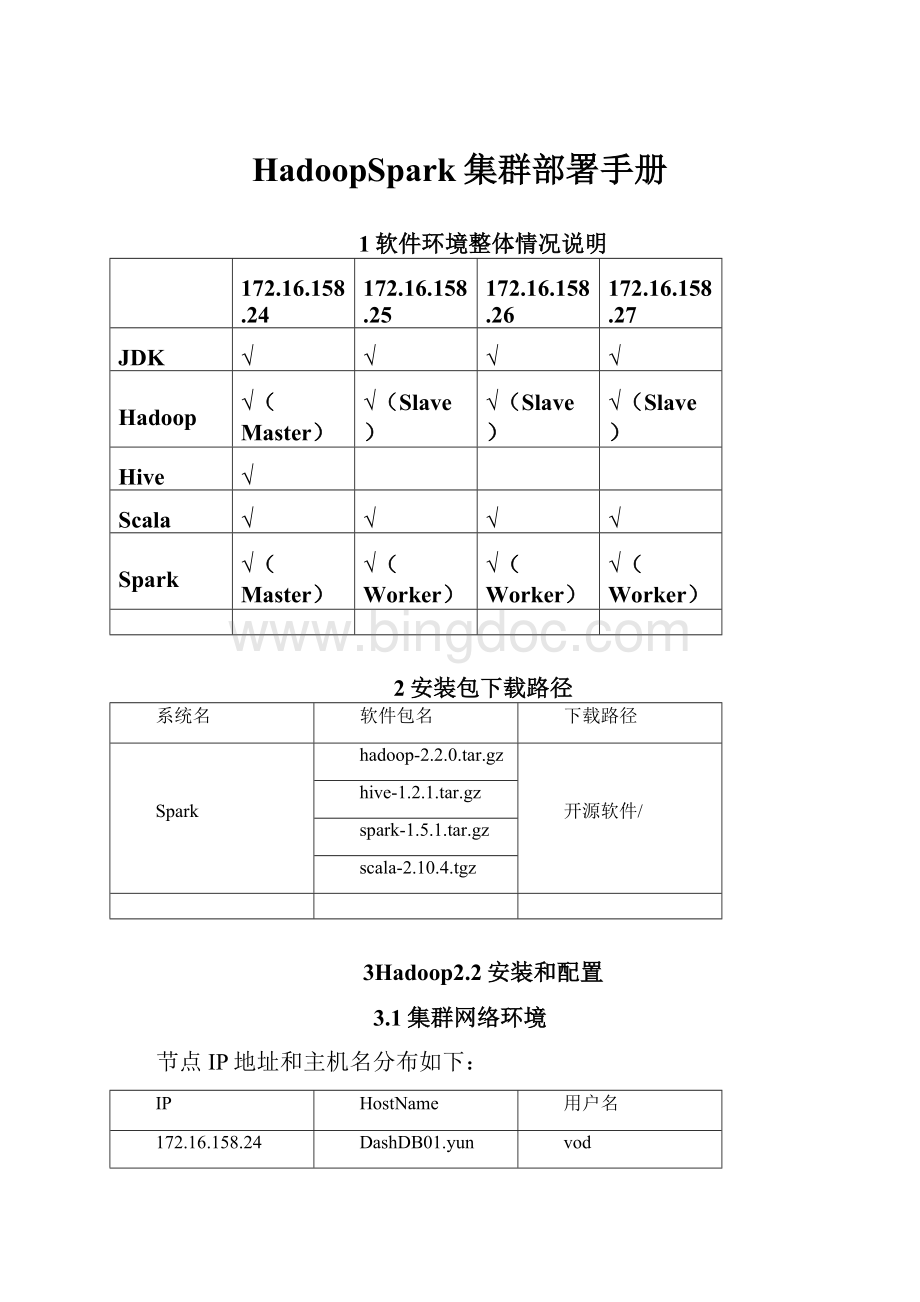

spark03.yun

3.2环境搭建(每台机器都要操作)

3.2.1修改HostName(非必须)

vim/etc/sysconfig/network

修改HOSTNAME为需要的名称

重启服务器,进行生效

reboot

3.2.2设置Host映射文件

1.

使用root身份编辑/etc/hosts映射文件,设置IP地址及机器名的映射,设置信息如下:

vim/etc/hosts

172.16.158.24DashDB01.yun

172.16.158.25spark01.yun

172.16.158.26spark02.yun

172.16.158.27spark03.yun

2.

使用如下命令对网络设置进行重启

/etc/init.d/networkrestart

3.

验证设置是否成功

3.2.3设置操作系统环境

3.2.3.1关闭防火墙

在Hadoop安装过程中需要关闭防火墙和SElinux,否则会出现异常

serviceiptablesstatus

查看防火墙状态,如下所示表示iptables已经开启

以root用户使用如下命令关闭iptables

chkconfigiptablesoff

3.2.3.2关闭SElinux

使用getenforce命令查看是否关闭

修改/etc/selinux/config

文件

将SELINUX=enforcing改为SELINUX=disabled,执行该命令后重启机器生效

3.2.3.3JDK安装及配置

赋予vod用户/usr/lib/java目录可读写权限,使用命令如下:

sudochmod-R777/usr/lib/java

把下载的安装包,上传到/usr/lib/java

目录下,使用如下命令进行解压

tar-zxvfjdk-7u55-linux-x64.tar.gz

解压后目录如下图所示:

使用root用户配置

/etc/profile,该设置对所有用户均生效

vim/etc/profile

添加以下信息:

exportJAVA_HOME=/usr/lib/java/jdk1.7.0_55

exportPATH=$PATH:

$JAVA_HOME/bin:

$JAVA_HOME/jre/bin

exportCLASSPATH=.:

$CLASSPATH:

$JAVA_HOME/lib:

$JAVA_HOME/jre/lib

修改完毕后,使用

source/etc/pro-version

3.2.3.4更新OpenSSL

yumupdateopenssl

3.2.3.5无密码验证配置

以root用户使用vim/etc/ssh/sshd_config,打开sshd_config配置文件,开放4个配置,如下图所示:

RSAAuthenticationyes

PubkeyAuthenticationyes

AuthorizedKeys

StrictModesno

配置后重启服务

servicesshdrestart

3.使用root用户登录在4个节点,在/home/common目录下,执行命令

mkdir.ssh

4.

使用vod用户登录在4个节点中使用如下命令生成私钥和公钥;

sudochown-Rvod.ssh

ssh-keygen-trsa

5.

进入/home/common/.ssh目录在4个节点中分别

使用如下命令cpid_rsa.pubauthorized_keys_DashDB01.yun

把公钥命名

authorized_keys_DashDB01.yun

authorized_keys_spark01.yun

authorized_keys_spark02.yun

authorized_keys_spark03.yun

6.

把3个从节点(spark01,spark02,spark03)的公钥使用scp命令传送到DashDB01.yun节点的/home/common/.ssh文件夹中;

scpauthorized_keys_spark01.yun:

/home/common/.ssh

最终DashDB01.yun节点中文件如下

7.

把4个节点的公钥信息保存到authorized_key文件中

使用catauthorized_keys_DashDB01.yun>

>

authorized_keys

命令

8.

把该文件分发到其他两个从节点上

使用scpauthorized_keys:

/home/common/.ssh把密码文件分发出

其余三台机器的.ssh文件包含如下:

9.

在4台机器中使用如下设置authorized_keys读写权限

chmod775authorized_keys

10.

测试ssh免密码登录是否生效

3.3配置Hadooop设置

3.3.1准备hadoop文件

把hadoop-2.2.0目录移到/usr/local目录下

cd/home/hadoop/Downloads/

sudocphadoop-2.2.0/usr/local

使用chown命令遍历修改hadoop-1.1.2目录所有者为hadoop

sudochown-Rvod/usr/local/hadoop-2.2.0

chmod775-R/usr/local/hadoop-2.2.0/

3.3.2在Hadoop目录下创建子目录

使用vod用户在hadoop-2.2.0目录下创建tmp、name和data目录,保证目录所有者为vod

cd/usr/local/hadoop-2.2.0

mkdirtmp

mkdirname

mkdirdata

ls

配置/etc/provim/etc/profile

添加以下内容

exportHADOOP_HOME=/usr/local/hadoop-2.2.0

$HADOOP_HOME/bin

exportYARN_HOME=$HADOOP_HOME

exportHADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

exportYARN_CONF_DIR=$HADOOP_HOMR/etc/hadoop

使用命令使其生效

source/etc/profile

3.3.3配置hadoop-env.sh

打开配置文件hadoop-env.sh

cd/usr/local/hadoop-2.2.0/etc/hadoop

sudovimhadoop-env.sh

加入配置内容,设置了hadoop中jdk和hadoop/bin路径

/usr/local/hadoop-2.2.0/bin

编译配置文件hadoop-env.sh,并确认生效

sourcehadoop-env.sh

3.3.4配置yarn-env.sh

在/usr/local/hadoop-2.2.0/etc/hadoop打开配置文件yarn-env.sh

sudovimyarn-env.sh

编译配置文件yarn-env.sh,并确认生效

sourceyarn-env.sh

3.3.5配置core-site.xml

使用如下命令打开core-site.xml配置文件

sudovimcore-site.xml

在配置文件中,按照如下内容进行配置

<

configuration>

<

property>

name>

fs.default.name<

/name>

value>

hdfs:

//172.16.158.24:

9000<

/value>

/property>

fs.defaultFS<

io.<

131072<

hadoop.tmp.dir<

description>

Abaseforothertemporarydirectories.<

/description>

hadoop.proxyuser.hduser.hosts<

*<

hadoop.proxyuser.hduser.groups<

/configuration>

3.3.6配置hdfs-site.xml

使用如下命令打开hdfs-site.xml配置文件

sudovimhdfs-site.xml

dfs.namenode.secondary.http-address<

172.16.158.24:

9001<

dfs.namenode.name.dir<

dfs.datanode.data.dir<

dfs.replication<

2<

dfs.webhdfs.enabled<

true<

dfs.permissions<

false<

3.3.7配置mapred-site.xml

默认情况下不存在mapred-site.xml文件,可以从模板拷贝一份

cpmapred-site.xml.templatemapred-site.xml

使用如下命令打开mapred-site.xml配置文件

sudovimmapred-site.xml

mapreduce.framework.name<

yarn<

mapreduce.jobhistory.address<

10020<

mapreduce.jobhistory.webapp.address<

19888<

3.3.8配置yarn-site.xml

使用如下命令打开yarn-site.xml配置文件

sudovimyarn-site.xml

yarn.nodemanager.aux-services<

mapreduce_shuffle<

yarn.nodemanager.aux-services.mapreduce.shuffle.class<

org.apache.hadoop.mapred.ShuffleHandler<

yarn.resourcemanager.address<

8032<

yarn.resourcemanager.scheduler.address<

8030<

yarn.resourcemanager.resource-tracker.address<

8031<

yarn.resourcemanager.admin.address<

8033<

yarn.resourcemanager.webapp.address<

8088<

3.3.9配置slaves文件

设置从节点

sudovimslaves

修改为

spark03.yun

3.3.10向各节点分发hadoop程序

在spark01.yunspark02.yunspark03.yun

机器中创建/usr/local/hadoop-2.2.0目录,然后修改该目录所有权限

sudomkdir/usr/local/hadoop-2.2.0

sudochown

-Rvod/usr/local/hadoop-2.2.0

sudochmod775-R/usr/local/hadoop-2.2.0/

在DashDB01.yun机器上进入/usr/local/hadoop-2.2.0目录,使用如下命令把hadoop文件夹复制到其他3台

使用命令

scp-r*:

/usr/local/hadoop-2.2.0

在从节点查看是否复制成功

执行chmod775-R/usr/local/hadoop-2.2.0/

4.每个节点配置/etc/provim/etc/profile

3.4启动hadoop

3.4.1格式化namenode

./bin/hdfsnamenode-format

3.4.2启动hadoop

cd/usr/local/hadoop-2.2.0/sbin

./start-all.sh

3.4.3验证当前进行

此时执行jps命令

在DashDB01.yun上运行的进程有:

namenode,secondarynamenode,resourcemanager

spark01.yunspark02.yun和spark03.yun上面运行的进程有:

datanode,nodemanager

4Hive1.2.1安装和配置

4.1拷贝项目

sudocp-r/home/common/Downloads/hive-1.2.1/hive-1.2.1

更改文件夹所属

sudochown-Rvod/usr/local/hive-1.2.1

sudochmod775-R/usr/local/hive-1.2.1

exportHIVE_HOME=/usr/local/hive-1.2.1

exportPATH=$HIVE_HOME/bin:

$PATH

exportHIVE_CONF_DIR=$HIVE_HOME/conf

4.2配置hive(使用mysql数据源)

前提条件:

在mysql数据库建立hive用户并赋予相关权限

mysql>

CREATEUSER'

hive'

IDENTIFIEDBY'

mysql'

;

GRANTALLPRIVILEGESON*.*TO'

@'

%'

WITHGRANTOPTION;

flushprivileges;

cd$HIVE_CONF_DIR/

cphive-default.xml.templatehive-site.xml

vimhive-site.xml

修改下列参数:

javax.jdo.option.ConnectionURL<

jdbc:

mysql:

//192.168.15.150:

3306/hive?

createDatabaseIfNotExist=true<

javax.jdo.option.ConnectionDriverName<

com.mysql.jdbc.Driver<

javax.jdo.option.ConnectionUserName<

hive<

javax.jdo.option.ConnectionPassword<

执行命令

chmod775-R/usr/local/hive-1.2.1/

4.3启动HiveServer2(后台启动)

cd$HIVE_HOME/bin

nohuphive--servicehiveserver2&

测试:

netstat-an|grep10000或者使用jdbc连接测试

4.4测试

输入hive命令,启动hive

hive>

showtables;

OK

Timetaken:

4.824seconds

createtablehwz(idint,namestring);

0.566seconds

select*fromhwz;

0.361seconds

$hadoopdfs-lsr/user/hive

Warning:

$HADOOP_HOMEisdeprecated.

drwxr-xr-x-hadoopsupergroup02012-03-2212:

36/user/hive/warehouse

36/user/hive/warehouse/hwz

5Scala安装和配置

5.1拷贝安装包

cd/usr/lib

sudocp/home/common/Downloads/scala-2.10.4.tgzscala-2.10.4.tgz

5.2解压安装包

sudotar-xvfscala-2.10.4.tgz

sudormscala-2.10.4.tgz

给scala文件夹赋予相应的权限

sudochown-R