大数据实训Spark集群环境部署实验.docx

《大数据实训Spark集群环境部署实验.docx》由会员分享,可在线阅读,更多相关《大数据实训Spark集群环境部署实验.docx(13页珍藏版)》请在冰点文库上搜索。

大数据实训Spark集群环境部署实验

spark安装实验

【实验名称】

spark安装实验

【实验目的】

能够理解Spark存在的原因,了解Spark生态圈,了解Spark体系架构并理解Spark计算模型。

学会部署Spark集群并启动Spark集群,能够配置Spark集群使用HDFS

【实验要求】

要求实验结束时,每位学生均已构建出Spark集群:

hadoop1上部署主服务Master,hadoop2、hadoop3上部署从服务Worker;并启动Spark集群进行测试。

【实验环境】

【实验步骤】

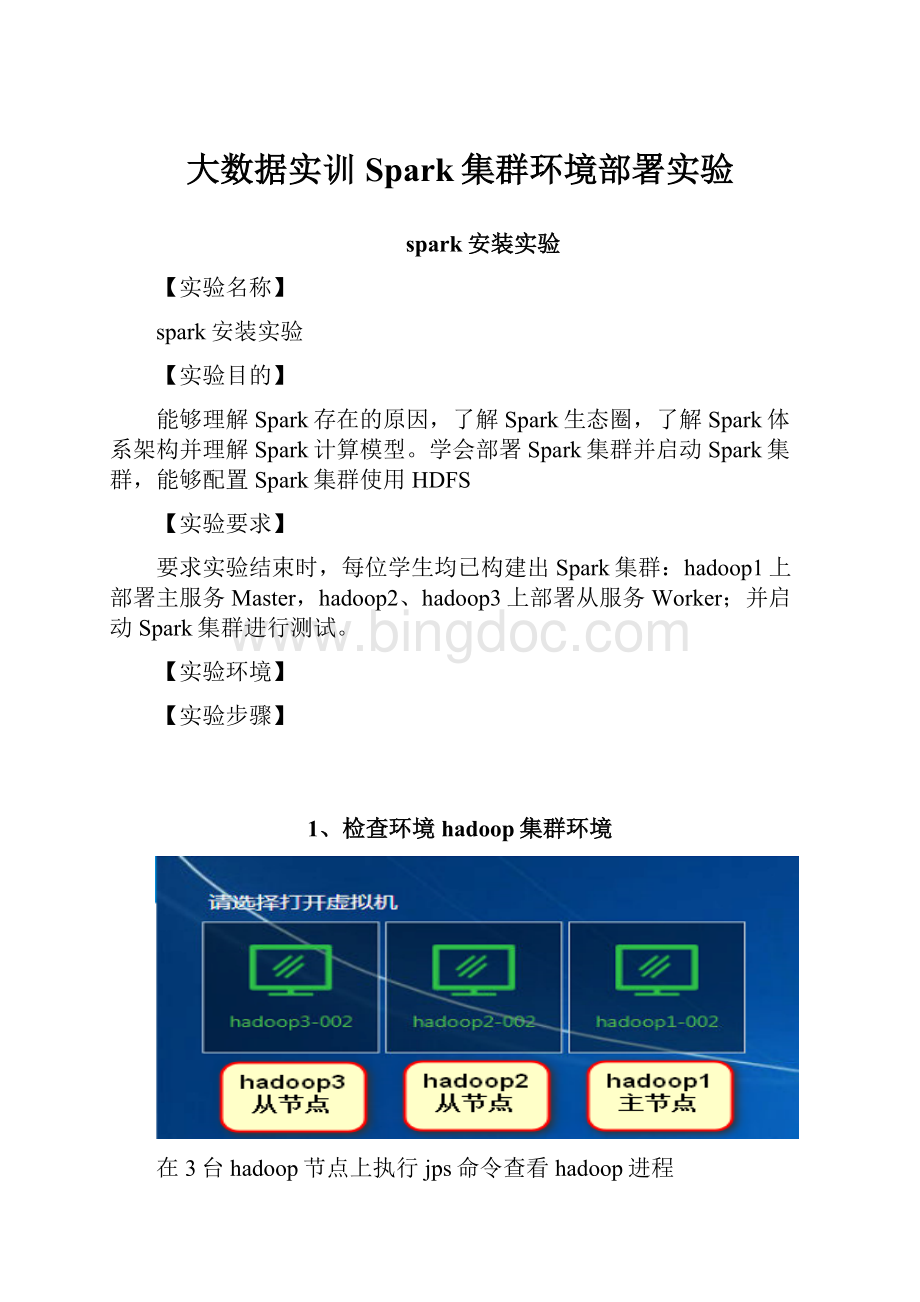

1、检查环境hadoop集群环境

在3台hadoop节点上执行jps命令查看hadoop进程

注意:

如果hadoop节点都没启动的话请按照第1课Hadoop3.1分布式集群按照课程中的3.1步骤进行启动

注意:

如果hadoop没有安装完成请安装第1课进行安装或执行自动部署脚本

hadoop1运行jps命令的截图:

hadoop2运行jps命令的截图:

hadoop3运行jps命令的截图:

2、Spark部署

进入hadoop1主节点,在桌面上打开终端

2.1进入软件安装包的目录

在终端执行命令:

cd/opt/hadoop-package

2.2将spark安装包解压缩到/opt目录下

在终端执行命令:

tar-zxvfspark-2.3.1-bin-hadoop2.7.gz-C/opt/

解压完成的截图:

2.3将scala安装包解压到/opt目录下

在终端执行命令:

tar-zxvfscala-2.11.8.tgz-C/opt/

解压完成的截图:

2.4进入/opt目录下

在终端执行命令:

cd/opt

2.5重命名spark

在终端执行命令:

mvspark-2.3.1-bin-hadoop2.7/spark-2.3.1

2.6重命名scala

在终端执行命令:

mvscala-2.11.8/scala

2.7进入spark配置文件目录

在终端执行命令:

cd/opt/spark-2.3.1/conf

2.8复制spark-env.sh.template文件为spark-env.sh

在终端执行命令:

cpspark-env.sh.templatespark-env.sh

2.9修改spark-env.sh文件

在终端执行命令:

vimspark-env.sh

在sparke-env.sh文件的最后面加入下面代码:

exportJAVA_HOME=/usr/lib/jdk1.8

exportSCALA_HOME=/opt/scala

exportHADOOP_HOME=/opt/hadoop-3.1.0

exportHADOOP_CONF_DIR=/opt/hadoop-3.1.0/etc/hadoop

exportSPARK_MASTER_IP=hadoop1

exportSPARK_WORKER_MEMORY=4g

exportSPARK_WORKER_CORES=2

exportSPARK_WORKER_INSTANCES=1

exportSPARK_DIST_CLASSPATH=$(${HADOOP_HOME}/bin/hadoopclasspath)

加入代码后的截图:

2.10复制slaves.template文件为slaves

在终端执行命令:

cpslaves.templateslaves

2.11编辑slaves文件

在终端执行命令:

vimslaves

在sparke-env.sh文件的最后面找到localhost并将这一行删除

删除localhost后的截图:

删除完成后再该文件的最后面加入下面两行代码:

hadoop2

hadoop3

加入代码后的截图:

2.12同步spark、scala文件到hadoop2和hadoop3上

将scala文件同步到hadoop2上

在终端执行命令:

scp-r/opt/scala/root@hadoop2:

/opt

同步完成的截图:

将scala文件同步到hadoop3上

在终端执行命令:

scp-r/opt/scala/root@hadoop3:

/opt

同步完成的截图:

将spark文件同步到hadoop2上

在终端执行命令:

scp-r/opt/spark-2.3.1/root@hadoop2:

/opt

同步完成的截图:

将spark文件同步到hadoop3上

在终端执行命令:

scp-r/opt/spark-2.3.1/root@hadoop3:

/opt

同步完成的截图: