CentOS64位环境下Hadoop260分布式部署说明Word文档下载推荐.docx

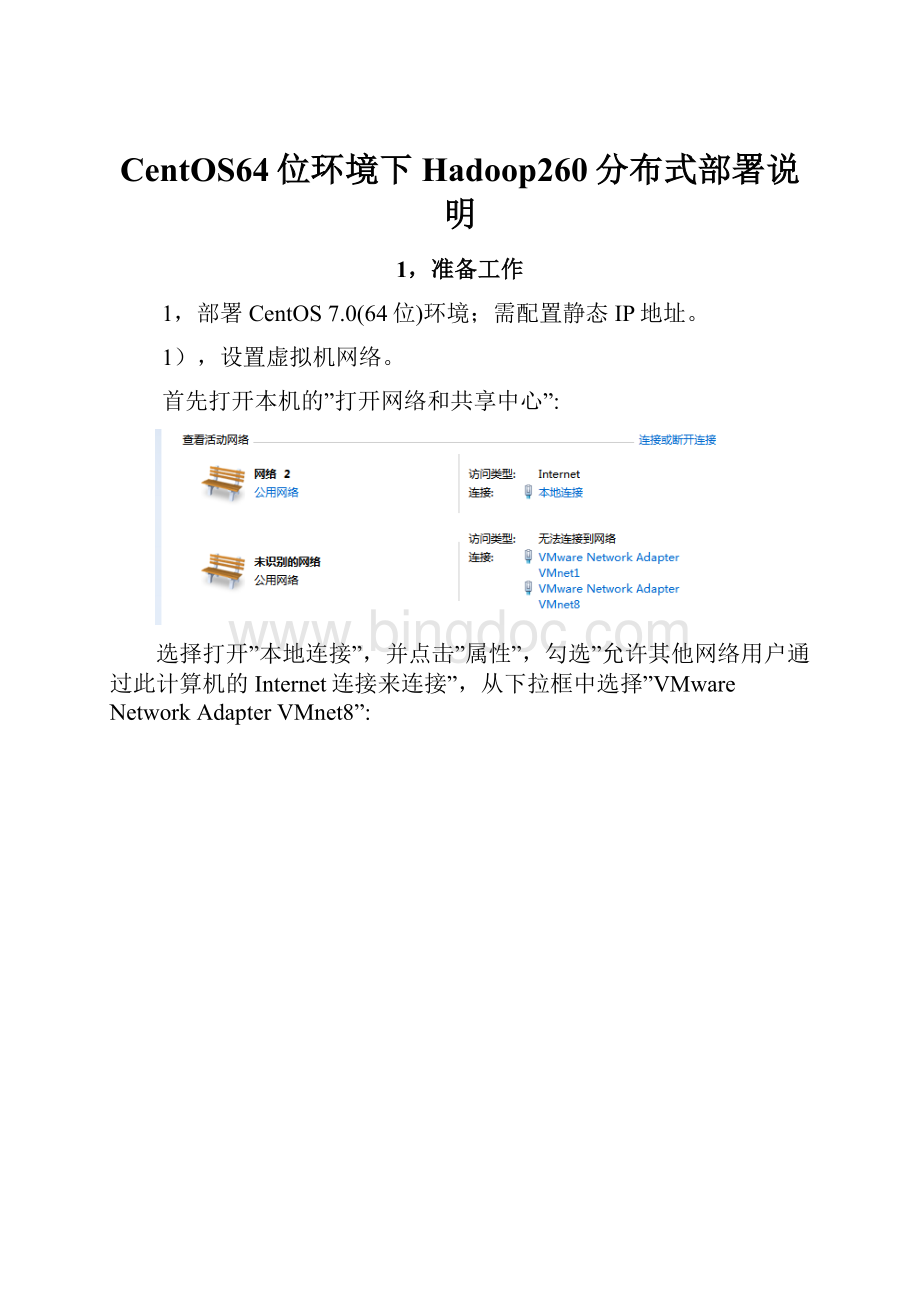

《CentOS64位环境下Hadoop260分布式部署说明Word文档下载推荐.docx》由会员分享,可在线阅读,更多相关《CentOS64位环境下Hadoop260分布式部署说明Word文档下载推荐.docx(16页珍藏版)》请在冰点文库上搜索。

yuminstalljava-1.8.0-openjdk-devel.x86_64

3),检查是否安装成功

java-version

可以看见当前的jdk版本已经是”1.8.0_91”。

表示已经安装成功。

3,安装Hadoop

1),将第一步下载的hadoop版本安装包上传至/usr/local/文件夹,并解压。

cd/usr/local

gunziphadoop-2.6.0.tar.gz

tar-xvfhadoop-2.6.0.tar

2),配置环境

打开/etc/profile

在文件的最后位置,追加上如下配置:

#set

java

environment

export

JAVA_HOME=/usr/lib/jvm/java

JRE_HOME=$JAVA_HOME/jre

PATH=$PATH:

$JAVA_HOME/bin

CLASSPATH=.:

$JAVA_HOME/lib/dt.jar:

$JAVA_HOME/lib/tools.jar

HADOOP_HOME=/usr/local/hadoop-2.6.0

HADOOP_CONF_DIR=/usr/local/hadoop-2.6.0/etc/hadoop

YARN_CONF_DIR=/usr/local/hadoop-2.6.0/etc/hadoop

exportPATH=$HADOOP_HOME/bin:

$HADOOP_HOME/sbin:

$PATH

3),激活配置

source/etc/profile

4),创建hdfs相关目录

mkdir

/home/hadoop/hd_space/tmp

-p

mkdir/home/hadoop/hd_space/hdfs/name-p

mkdir/home/hadoop/hd_space/hdfs/data-p

mkdir/home/hadoop/hd_space/mapred/local-p

-p

/home/hadoop/hd_space/mapred/system

chown

-R

hadoop:

hadoop

/home/hadoop/hd_space/

/usr/local/hadoop-2.6.0

4,虚拟机克隆

1),选择菜单栏中的“虚拟机->

管理->

克隆”。

选择”创建完整克隆”。

2),更改虚拟机的网卡

打开克隆虚拟机,“网络适配器”->

“高级”如下图:

MAC

datanode1:

HWADDR=00:

0C:

29:

10:

EC:

78

datanode2:

79

3),更改主机名主机ip配置

分别用root登录克隆的两台机器,打开并编辑/etc/hostname,分别输入datanode1和datanode2。

打开/etc/sysconfig/network-scripts/ifcfg-eno16777756,修改相关内容:

IPADDR=192.168.128.111

IPADDR=192.168.128.112

4),重启3台虚拟机。

5,3台虚拟机建立互连

1),root登陆namenode,打开并编辑/etc/hosts,修改内容:

192.168.128.110namenode

192.168.128.111datanode1

192.168.128.112datanode2

2),将修改后的文件,分别拷贝到datanode1和datanode2

在终端执行如下指令:

scp/etc/hostsroot@192.168.128.111:

/etc/hosts

scp/etc/hostsroot@192.168.128.112:

3),通过SSH建立互连

用hadoop分别登陆namenode、datanode1、datanode2。

ssh-keygen

-t

rsa采用默认值3次回车。

在datanode1登录hadoop用户

scp

/home/hadoop/.ssh/id_rsa.pub

hadoop@namenode:

/home/hadoop/.ssh/id_rsa.pub.datanode1

在datanode2登录hadoop用户

/home/hadoop/.ssh/id_rsa.pub.datanode2

在namenode登录hadoop用户

cd

/home/hadoop/.ssh/

ll

cat

id_rsa.pub

>

authorized_keys

id_rsa.pub.datanode1

id_rsa.pub.datanode2

~/.ssh/authorized_keys

hadoop@datanode1:

/home/hadoop/.ssh/authorized_keys

hadoop@datanode2:

chmod

600

备注:

无密码登陆,需要600权限(三台机器分别执行chmod

)。

4),测试连通:

在namenode上分别执行:

sshdatanode1

sshdatanode2

在datanode1上执行sshnamenode和sshdatanode2

在datanode2一样参照上述命令进行验证。

6,Hadoop配置

修改路径

/usr/local/hadoop-2.5.2/etc/hadoop

下的配置文件。

1),编辑hadoop-env.sh

修改JAVA_HOME并保存

”export

JAVA_HOME=/usr/lib/jvm/java”

2),编辑yarn-env.sh

修改

JAVA_HOME并保存

JAVA_HOME=/usr/lib/jvm/java

3),编辑core-site.xml

<

property>

name>

fs.defaultFS<

/name>

value>

hdfs:

//namenode:

9000<

/value>

/property>

hadoop.tmp.dir<

/home/hadoop/hd_space/tmp<

<

io.file.buffer.size<

4096<

4),编辑hdfs-site.xml

dfs.namenode.name.dir<

/home/hadoop/hd_space/hdfs/name<

dfs.datanode.data.dir<

/home/hadoop/hd_space/hdfs/data<

dfs.replication<

2<

dfs.namenode.secondary.http-address<

50090<

dfs.namenode.secondary.https-address<

50091<

5),编辑mapred-site.xml

mapreduce.cluster.local.dir<

/home/hadoop/hd_space/mapred/local<

mapreduce.cluster.system.dir<

/home/hadoop/hd_space/mapred/system<

mapreduce.framework.name<

yarn<

mapreduce.jobhistory.address<

namenode:

10020<

mapreduce.jobhistory.webapp.address<

19888<

6),编辑yarn-site.xml

description>

The

hostname

of

the

RM.<

/description>

yarn.resourcemanager.hostname<

namenode<

valid

service

name

should

only

contain

a-zA-Z0-9_

and

can

not

start

with

numbers

yarn.nodemanager.aux-services<

mapreduce_shuffle<

7),修改slaves

打开/usr/local/hadoop-2.6.0/etc/hadoop/slaves,将里面的localhost改为datanode1和datanode2

8),修改datanode1和datanode2的hadoop配置

将namenode修改的配置文件,拷贝到datanode1和datanode2

-r

/usr/local/hadoop-2.6.0/etc/hadoop

/usr/local/hadoop-2.6.0/etc

scp

7,启动hadoop

1),格式化执行命令hdfsnamenode-format。

初次运行,首先要进行格式化(一次就够)

2),启动dfs及yarn

执行如下指令start-dfs.sh

执行如下指令start-yarn.sh

或者直接执行start-all.sh效果和上述两个命令一样。

相应的对应中止命令分别为

stop-dfs.sh

stop-yarn.sh

stop-all.sh

3),前台验证

http:

//192.168.128.110:

50070/dfshealth.jsp

可以看到LiveNodes个数为2

http:

8088/cluster

4),检查进程

检查进程

:

5),检查日志文件

/usr/local/hadoop-2.6.0/logs

6),删除日志

rm

-rf

/usr/local/hadoop-2.6.0/logs/*.*