Hadoop安装部署文档.docx

《Hadoop安装部署文档.docx》由会员分享,可在线阅读,更多相关《Hadoop安装部署文档.docx(12页珍藏版)》请在冰点文库上搜索。

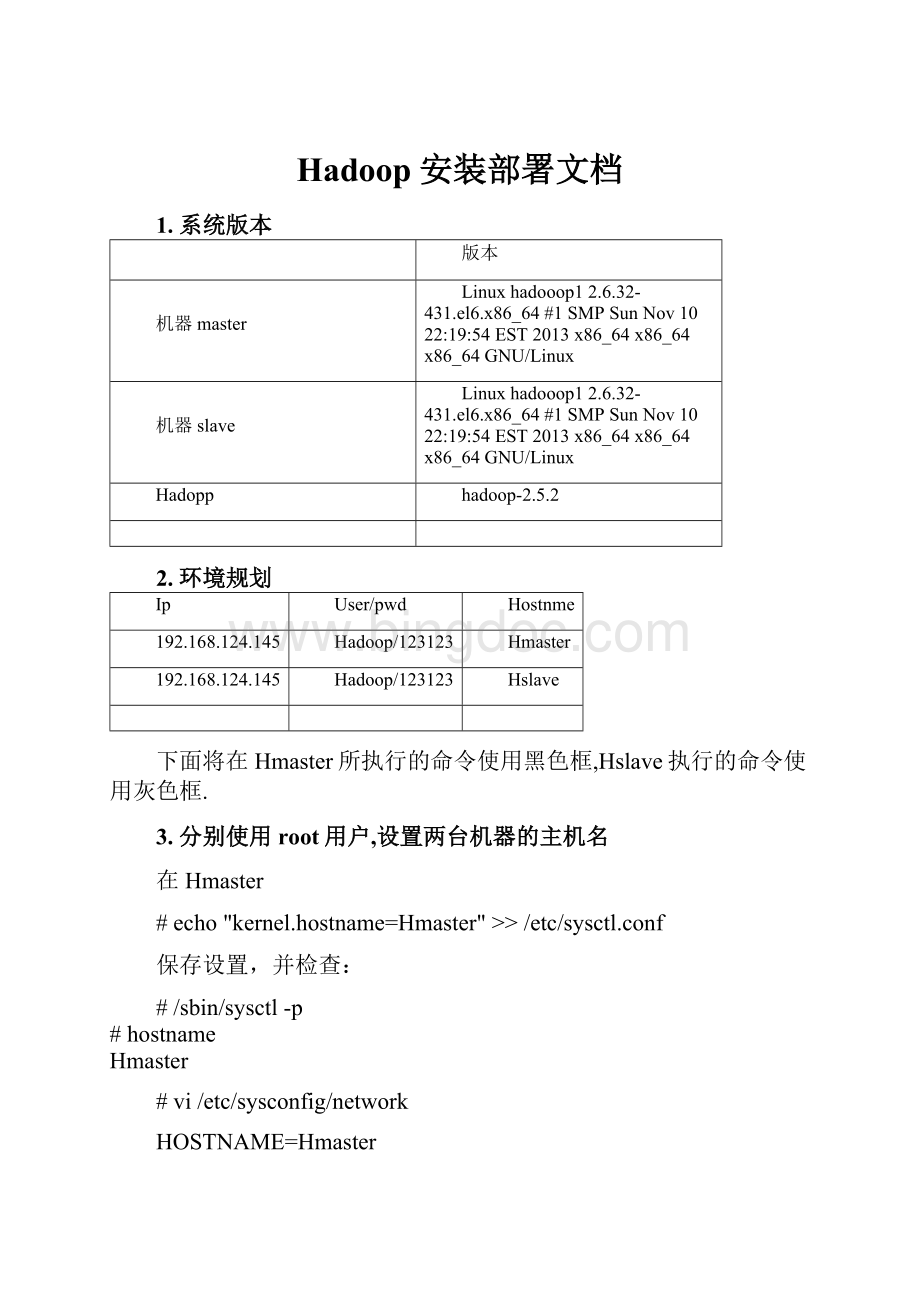

Hadoop安装部署文档

1.系统版本

版本

机器master

Linuxhadooop12.6.32-431.el6.x86_64#1SMPSunNov1022:

19:

54EST2013x86_64x86_64x86_64GNU/Linux

机器slave

Linuxhadooop12.6.32-431.el6.x86_64#1SMPSunNov1022:

19:

54EST2013x86_64x86_64x86_64GNU/Linux

Hadopp

hadoop-2.5.2

2.环境规划

Ip

User/pwd

Hostnme

192.168.124.145

Hadoop/123123

Hmaster

192.168.124.145

Hadoop/123123

Hslave

下面将在Hmaster所执行的命令使用黑色框,Hslave执行的命令使用灰色框.

3.分别使用root用户,设置两台机器的主机名

在Hmaster

#echo"kernel.hostname=Hmaster">>/etc/sysctl.conf

保存设置,并检查:

#/sbin/sysctl-p

#hostname

Hmaster

#vi/etc/sysconfig/network

HOSTNAME=Hmaster

然后,设置主机名和IP对应关系:

#vi/etc/hosts

192.168.124.145Hmaster

192.168.124.146Hslave

在Hslave

#echo"kernel.hostname=Hslave">>/etc/sysctl.conf

保存设置,并检查:

#/sbin/sysctl-p

#hostname

Hslave

然后,设置主机名和IP对应关系:

#vi/etc/hosts

192.168.124.145Hmaster

192.168.124.146Hslave

4.分别创建用户Hmaster、Hslave

在Hmaster使用root用户创建Hadoop组,Hadoop用户

#groupaddHadoop

#useradd-gHadoopHadoop

#passwdHadoop

在Hslave使用root用户创建Hadoop组,Hadoop用户

#groupaddHadoop

#useradd-gHadoopHadoop

#passwdHadoop

5.设置两台机器ssh无密码登录

一般系统是默认安装了ssh命令的,如果没有,自行安装。

在Hmaster,切换到Hadoop用户

第一步:

产生密钥

$ssh-keygen-tdsa-P''-f~/.ssh/id_dsa

Generatingpublic/privatedsakeypair.

Createddirectory'/home/Hadoopm/.ssh'.

Youridentificationhasbeensavedin/home/Hadoopm/.ssh/id_dsa.

Yourpublickeyhasbeensavedin/home/Hadoopm/.ssh/id_dsa.pub.

Thekeyfingerprintis:

6e:

96:

18:

54:

e0:

01:

0f:

09:

d8:

ba:

9b:

87:

40:

c3:

d8:

6dHadoopm@Hmaster

Thekey'srandomartimageis:

+--[DSA1024]----+

|o..ooo..|

|...+o|

|oo.+|

|o+.E.|

|.....S|

|o+.|

|.+.=|

|+.o|

|.|

+-----------------+

第二步:

导入authorized_keys

$cat~/.ssh/id_dsa.pub>>~/.ssh/authorized_keys

$chmod600authorized_keys

第三步:

ssh无密码连接测试

$sshHmaster

第一次登录需要密码,exit退出后,重新登录不需要

☆如果出现提示

$ssh-oStrictHostKeyChecking=noHmaster

同样,在Hslave,切换到Hadoop用户

产生密钥

$ssh-keygen-tdsa-P''-f~/.ssh/id_dsa

Generatingpublic/privatedsakeypair.

Youridentificationhasbeensavedin/home/Hadoops/.ssh/id_dsa.

Yourpublickeyhasbeensavedin/home/Hadoops/.ssh/id_dsa.pub.

Thekeyfingerprintis:

a6:

c2:

c8:

17:

76:

95:

8a:

9a:

3d:

c9:

f1:

61:

67:

2d:

09:

c5Hadoops@Hslave

Thekey'srandomartimageis:

+--[DSA1024]----+

|..|

|.E.|

|.o|

|.+o|

|==S.|

|.OB*.|

|=Oo|

|.o|

||

+-----------------+

导入authorized_keys

$cat~/.ssh/id_dsa.pub>>~/.ssh/authorized_keys

$chmod600authorized_keys

ssh无密码连接测试

$sshHslave

第四步:

设置Hmaster与Hslave机器相互无密访问

进入Hmaster机器Hadoop用户的.ssh目录(Hadoop用户)

$scpauthorized_keysHadoop@Hslave:

~/.ssh/authorized_keys_from_master

输入Hslave机器Hadoop的密码(Hadoop用户)

Hadoops@hslave'spassword:

authorized_keys100%6050.6KB/s00:

00

进入Hslave机器Hadoop的.ssh目录(Hadoop用户)

$catauthorized_keys_from_master>>authorized_keys

$scpauthorized_keysHadoop@Hmaster:

~/.ssh/authorized_keys_from_slave

输入Hmaster机器Hadoop的密码(Hadoop用户)

Hadoop@hmaster'spassword:

authorized_keys100%12071.2KB/s00:

00

进入Hmaster机器Hadoop用户的.ssh目录(Hadoop用户)

$catauthorized_keys_from_slave>>authorized_keys

第五步:

互相测试无密登录

在Hmaster机器(Hadoop用户)

$sshHslave

Lastlogin:

TueNov123:

55:

422016fromhmaster

成功。

在Hslave机器(Hadoop用户)

$sshHmaster

Lastlogin:

TueNov123:

56:

132016fromhslave

成功。

6.安装jdk

上传jdk到Hmaster及Hslave机器,并执行以下命令(Hadoop用户)

$tar-zxvfjdk-7u75-linux-x64.tar.gz

复制jdk解压路径,设置Hadoop用户环境变量

$vi~/.bash_profile

exportJAVA_HOME=/home/Hadoop/jdk1.7.0_75

exportCLASSPATH=.:

$JAVA_HOME/lib/tools.jar:

$JAVA_HOME/lib/dt.jar

exportPATH=$JAVA_HOME/bin:

$PATH

7.安装hadoop-2.5.2

1.解压在Hmaser机器,解压hadoop-2.5.2.tar.gz,并创建以下文件夹(Hadoop用户)

$tar-zxvfhadoop-2.5.2.tar.gz

$mkdir~/dfs/

$mkdir~/dfs/name

$mkdir~/dfs/data

$mkdir~/tmp

2.修改配置文件

进入/home/Hadoop/hadoop-2.5.2/etc/hadoop目录(Hadoop用户)

$cd/home/Hadoop/hadoop-2.5.2/etc/hadoop

2.1.修改core-site.xml

$vicore-site.xml

hadoop.tmp.dir

/home/Hadoop/tmp

Abaseforothertemporarydirectories.

fs.defaultFS

hdfs:

//Hmaster:

9000

io.file.buffer.size

4096

2.2.修改hdfs-site.xml

$vihdfs-site.xml

dfs.nameservices

hadoop-cluster1

dfs.namenode.secondary.http-address

Hmaster:

50090

dfs.namenode.name.dir

file:

///home/Hadoop/dfs/name

dfs.datanode.data.dir

file:

///home/Hadoop/dfs/data

dfs.replication

1

dfs.webhdfs.enabled

true

2.3.修改mapred-site.xml

$cpmapred-site.xml.templatemapred-site.xml

$vimapred-site.xml

mapreduce.framework.name

yarn

mapreduce.jobtracker.http.address

Hmaster:

50030

mapreduce.jobhistory.address

Hmaster:

10020

mapreduce.jobhistory.webapp.address

Hmaster:

19888

2.4.修改yarn-site.xml

yarn.nodemanager.aux-services

mapreduce_shuffle

yarn.resourcemanager.address

Hmaster:

8032

yarn.resourcemanager.scheduler.address

Hmaster:

8030

yarn.resourcemanager.resource-tracker.address

Hmaster:

8031

yarn.resourcemanager.admin.address

Hmaster:

8033

yarn.resourcemanager.webapp.address

Hmaster:

8088

8088为访问hadoop端口

2.5.修改slaves

$vislaves

Hslave

2.6.修改hadoop-env.sh

$vihadoop-env.sh

exportJAVA_HOME=/home/Hadoop/jdk1.7.0_75

2.7.修改yarn-env.sh

$viyarn-env.sh

exportJAVA_HOME=/home/Hadoop/jdk1.7.0_75

3.将hadoop-2.5.2文件夹传输到Hslave

$scp~/hadoop-2.5.2Hadoop@Hslave:

~/

8.格式化文件系统

在机器Hmaster及Hslave

$/home/Hadoop/hadoop-2.5.2/bin/hdfsnamenode -format

注意:

这里的格式化文件系统并不是硬盘格式化,只是针对主服务器hdfs-site.xml的dfs.namenode.name.dir和dfs.datanode.data.dir目录做相应的清理工作。

9.启动hdfs:

在Hmaster

$/home/Hadoop/hadoop-2.5.2/sbin

$./start-dfs.sh

如果提示util.NativeCodeLoader:

Unabletoloadnative-hadooplibraryforyourplatform

则上传hadoop-native-64-2.5.2所以文件覆盖至/home/Hadoop/hadoop-2.5.2/lib/native/

下载地址(

10.启动yarn:

在Hmaster

$/home/Hadoop/hadoop-2.5.2/sbin

$./start-yarn.sh

11.查看进程信息

在Hmaster

在Hslave

12.查看HDFS集群状态

http:

//Hmaster:

50070/

http:

//Hmaster:

8088/

13.关闭hdfs:

$/home/Hadoop/hadoop-2.5.2/sbin

$./stop-dfs.sh

14.关闭yarn:

$/home/Hadoop/hadoop-2.5.2/sbin

$./stop-yarn.sh