第六章人工神经元计算方法.docx

《第六章人工神经元计算方法.docx》由会员分享,可在线阅读,更多相关《第六章人工神经元计算方法.docx(16页珍藏版)》请在冰点文库上搜索。

第六章人工神经元计算方法

第六章人工神经元计算方法

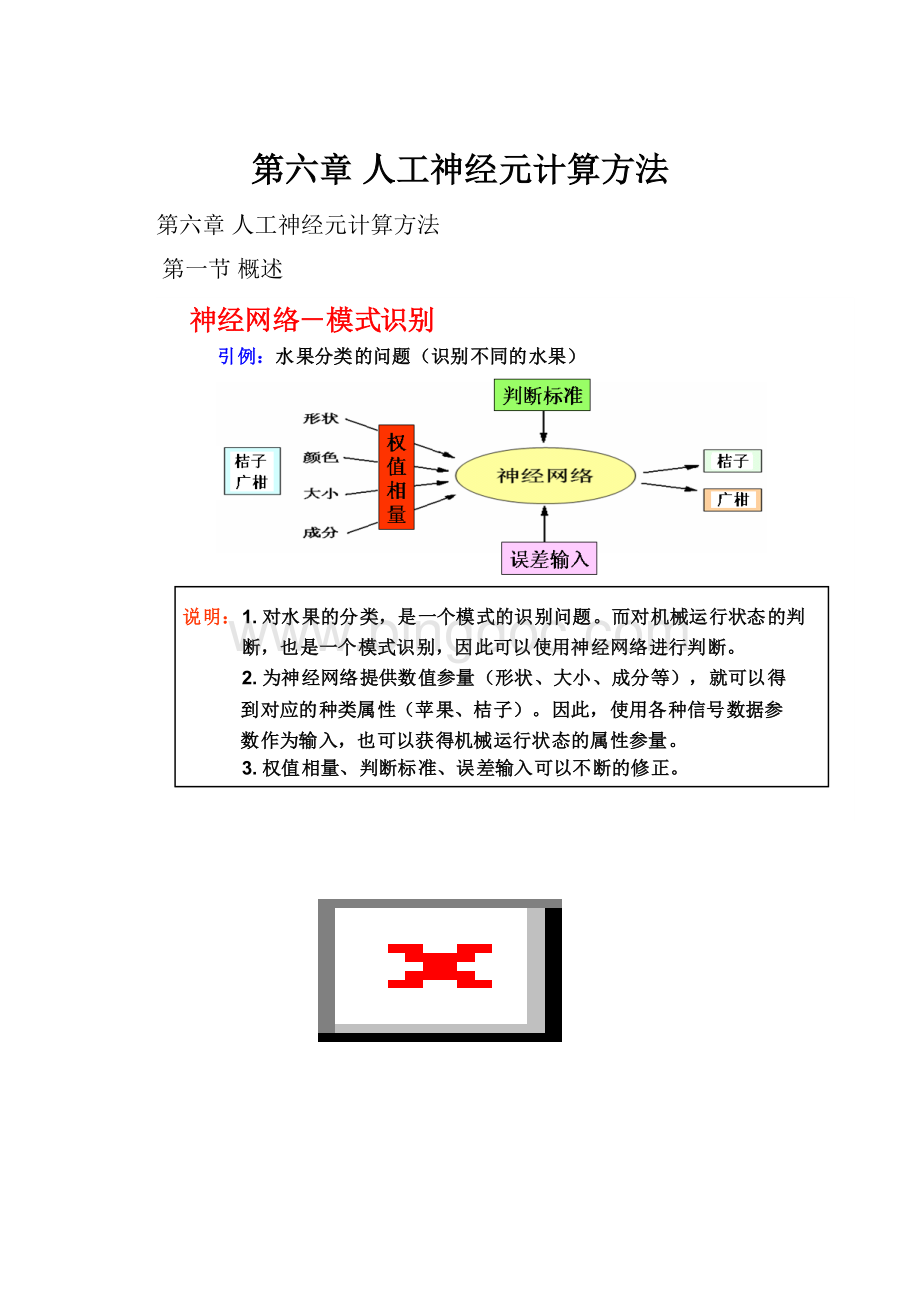

第一节概述

神经网络理论的应用取得了令人瞩目的发展,特别是在人工智能、自动控制、计算机科学、信息处理、机器人、模式识别、CAD/CAM等方面都有重大的应用实例。

下面列出一些主要应用领域:

(1)模式识别和图像处理。

语音识别、签字识别、指纹识别、人体病理分析、目标检测与识别等。

(2)控制和优化。

机械过程控制、机器人运动控制、金属探伤、故障分析等。

(3)预报和智能信息管理。

股票市场预测、地震预报、有价证券管理、借贷风险分析、IC卡管理和交通管理。

一、什么是人工神经元计算

人的大脑是众所周知的最复杂的计算“装置”,其强大的思考、记忆和解决问题的能力激发了许多科学工作者去尝试建立人脑的计算模型。

经过近半个多世纪的努力,形成了人工神经元计算理论。

1.模拟人脑神经元是脑神经系统中最基本的细胞单元。

每个神经元都是一个简单的微处理单元,其接受和综合许多其它神经元通过所谓树突的输入结构传来的信号,并将输出信号沿着轴突向外传送。

这种信号传递本质上是一个化学过程,但其信号是可以测量的。

2.人工神经元网络

在人工神经元网络中,模拟生物神经元的单元一般称为神经元。

一个神经元有许多输入通道(树突),它通常用简单求和的方式对所有输入值进行合成操作。

操作结果是神经元的一个内部激发值,由传递函数作进一步的修改。

传递函数可以是阈值函数,只有当激发值达到一定水平时才输出信号。

传递函数也可以是合成输入的连续函数。

传递函数的输出值接传送到神经元的输出通道。

常用传递函数形式如下所示。

神经元的信号处理过程如图6-2所示。

神经元的输出通道可通过一个相应的权,输入到神经元的信号在求和前进进行权操作。

因此,和函数实际上是一个加权和。

Wj1神经元

Wj2输出

.

.Wjn

.

联结权

图6-2神经元的计算模型

神经元网络由许多相互联结在一起的神经元所组成。

神经元按层进行组织,连续两层之间全部或随机联结。

通常有两层与外界联系即输入与输出层,其他层称为隐层。

3.网络计算

神经元网络的计算分两个阶段——学习和记忆。

网络学习,即对网络进行训练,是一个根据施加在输入层与输出层的刺激来调整网络联结权的计算过程。

输出层的刺激对应于给定输入之期望响应,必须由有经验的“教师”给出。

这种学习称为有导师的学习。

2、人工神经元计算的特点

神经元计算不同事传统的计算与人工智能,主要现在如下几个方面:

1.样本学习

传统专家系统(一种模拟人类专家解决领域问题的计算机程序系统)的知识是用规则的形式给出的。

神经网络与专家系统不同,其规则是由样本学习形成的。

其中学习规则是根据样本输入及期望输出来调整网络联结权的方法。

2.分布联想记忆

神经元计算网络的一个重要特征是其储存信息的方式。

神经元计算是分布记忆的,联结权为神经网络的记忆单元,权值体现了网络知识的当前状态。

由一对输入—期望输出样本表示的一条知识分布在网络的多个记忆单元里,与储存在网络内的其他条知识共享这些记忆单元。

3.容错特性

传统的计算系统只要损坏少量的记忆单元,就不能正常工作。

神经元计算系统则是能容错的。

容错是一些神经元破坏损伤后或联结少许再变差一点。

神经元计算系统之所以能够容错,是因为信息不是储存在一个地方,而是分布在整个系统的联接内。

4.综合能力

神经元网络能够学习复杂连续的映射。

综合复杂连续函数的能力类似于生理系统学习协调运动的能力,如学习挥动球拍和击球。

第二节反向传播网络(BP-BackPropagation)

反向传播神经元网络是使用最广泛的一种神经网络,成功地应用于很多领域,其中包括文字识别、目标跟踪、图像分类、信号处理、运动控制及故障诊断等等。

反向传播网络可解决任何需要模式映射的问题,即给定一个输入模式,网络产生一个相关的输出模式。

反向传播网络是一种最容易理解的神经网络。

它的学习思想相当直观,即当网络输出有错误时,就修改联结权,使得误差减小。

训练过的网络能产生正确的输出响应。

BP算法(即反向传播法)的基本思想是:

学习过程由信号的正向传播与误差的反向传播两个过程组成。

1)正向传播:

输入样本->输入层->各隐层(处理)->输出层

注1:

若输出层实际输出与期望输出(教师信号)不符,则转入2)(误差反向传播过程)

2)误差反向传播:

输出误差(某种形式)->隐层(逐层)->输入层

其主要目的是通过将输出误差反传,将误差分摊给各层所有单元,从而获得各层单元的误差信号,进而修正各单元的权值(其过程,是一个权值调整的过程)。

一、网络结构

反向传播网络通常有一个输入层,一个输出层和至少一个隐层,每层由一个以上的神经元所组成。

右图所示为一个典型的三层反向传播网的拓扑结构。

底层是输入层,其神经元接受外部输入;上层是输出层,其神经元给出网络的输出相应;中间层是隐层,其神经元与上下层的神经元相互联结。

右图所示为一个神经元,左边是输入,右边是接受神经元输出的神经元。

该神经元拥有一个输入加权和(Sj)一个输出值(αj),和一个相关的误差值(δj)。

这个误差在联结权调整时有用。

神经元i到j的权记为Wji,在网络学习时得以确定。

学习结束后权值是不变的,用于网络输出响应的计算,即前向传播计算。

二、网络运算与传递函数

网络远算是网络输入信号的前向传播和网络输出响应的计算。

当给网络一个输入信号时,信号就开始前向传播。

输入层每个神经元对应于输入矢量的一个分量,输入值取这个分量的值。

三、误差反向传播

误差反向传播是网络学习时联结权的修正量的计算从输出层开始,通过网络反向传播到输入层为止。

给定网络联结权的初值(通常是随机数),在输入样本信号的前向传播完成后开始进行比较误差校正。

首先由输出层各神经元的误差。

然后调整与输出值,并与训练样本的目标输出进行比较,计算出输出层各神经元的误差。

然后调整与输出层相联的联结权,再计算隐层各神经元的误差值。

接着调整与隐层相联的联结权。

上述过程到最后一层的权值调整完为止。

该算法实质是求误差函数的极小值,它通过多个样本的反复训练,并采用最快下降法使得权值沿着误差函数负梯度方向改变,并收敛于最小点。

四、网络训练与测试

网络训练实际上是一个确定联结权的学习过程。

反向传播网络用所谓有导师的学习技术来训练,即输入和目标输出训练样本成对地提代给网络。

训练样本是一个实数矢量。

目标输出是输入样本的期望响应,用来确定调整联结权所需的网络误差。

训练样本可重复使用。

一次训练迭代提供给网络一对输入-输出样本,一个训练循环包括所有的样本。

反向传播网络的训练通常需要成千上万次训练循环。

网络训练的收敛准则一般用输出误差的均方根(RMS)值不定义。

收敛是指RMS值越来越逼近0的过程。

常需要很长的时间。

如果训练样本具有代表性,网络一般可收敛到一个较小的RMS值。

若存在局部极小,可用一些技术,例如,改变学习参数或增加隐层神经元的数目,使网络避开局部最小。

给联结权一个随机摄动,也可使网络离开局部最小位置。

如果新的位置离开局部最小位置足够远,则收敛就朝新的方向进行,而不至于停滞在原先的最小位置。

习题

6-1什么是神经网络?

反向传播网至少有几层?

6-2为什么神经网络具有联想记忆、容错能力?

与网络结构有什么关系?

6-3神经网络信息主要存储在什么地方?

学习目的是什么?