【南开】《网络爬虫与信息提取》20春期末考核答卷(标准答案)Word文件下载.docx

《【南开】《网络爬虫与信息提取》20春期末考核答卷(标准答案)Word文件下载.docx》由会员分享,可在线阅读,更多相关《【南开】《网络爬虫与信息提取》20春期末考核答卷(标准答案)Word文件下载.docx(6页珍藏版)》请在冰点文库上搜索。

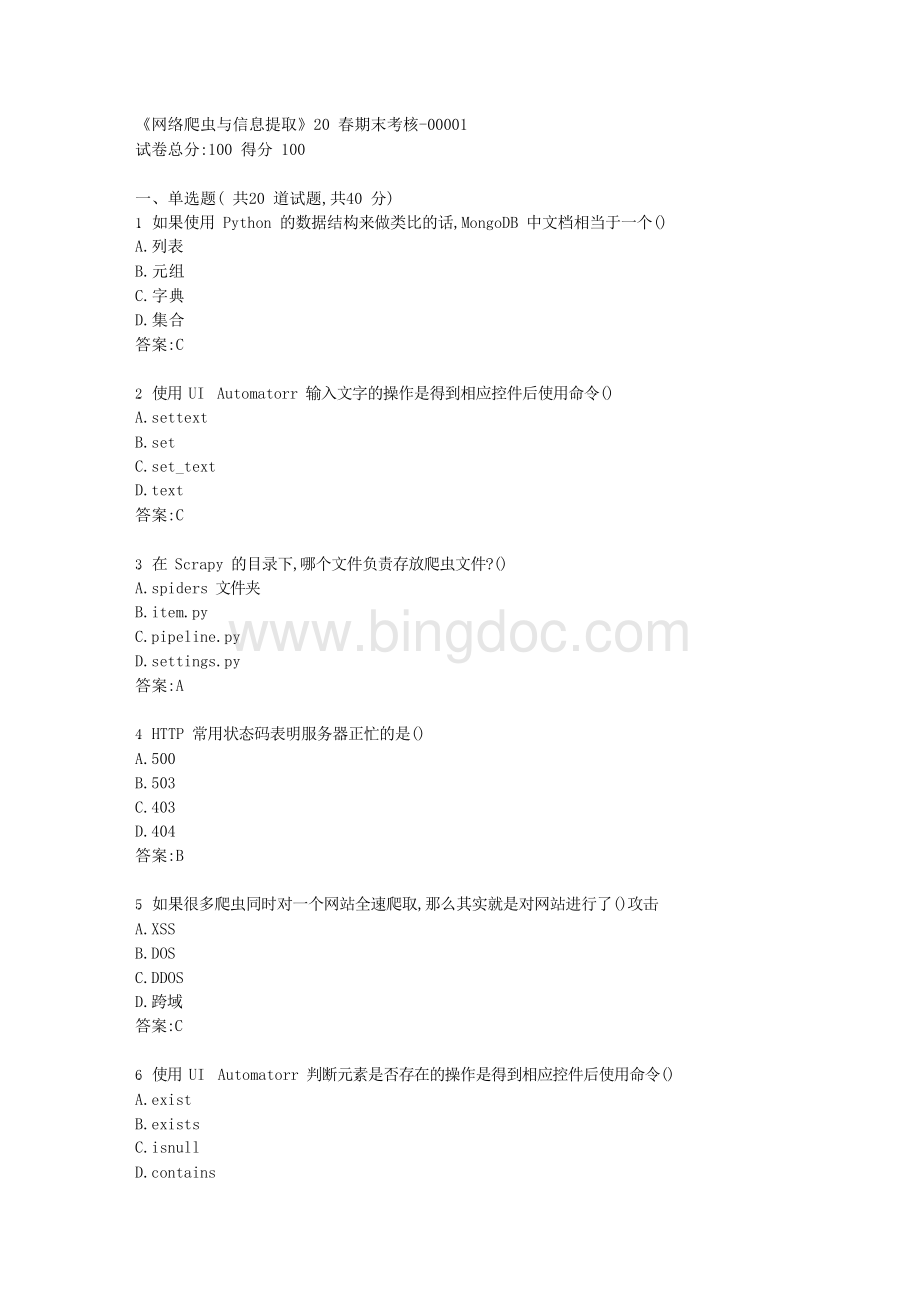

()A.spiders文件夹

B.item.pyC.pipeline.pyD.settings.py答案:

A

4.HTTP常用状态码表明服务器正忙的是()A.500

B.503

C.403D.404

B

5.如果很多爬虫同时对一个网站全速爬取,那么其实就是对网站进行了()攻击A.XSS

B.DOS

C.DDOS

D.跨域答案:

6.使用UIAutomatorr判断元素是否存在的操作是得到相应控件后使用命令()A.exist

B.exists

C.isnullD.contains

B

7.带上通过Chrome浏览器从评论页面复制而来的()再发起请求,可以减少爬虫被网站封锁的概率

A.Cookie

B.HtmlC.HeadersD.CSS

8.Redis中查看一个列表长度,使用关键字()A.len

B.length

C.llenD.count答案:

9.使用Xpath获取文本使用()A.text

B.text()

C.contentD.content()答案:

10.使用python定制mitmproxy,下面的语句请求的是()。

{req.headers["

User-Agent"

]}A.headers

B.文本内容C.目标网站

D.user-agent

D

11.Python中Object={1,2,3,4,5},则Objcet是()A.列表

12.在Scrapy的目录下,哪个文件负责存放爬虫的各种配置信息?

13.Redis是一个开源的使用()语言编写

A.ANSICB.C++C.JAVA

D.Python

14.某些网站在发起Ajax请求时会携带()字符串用于身份验证

A.TokenB.CookieC.ReqTimeD.sum

15.使用UIAutomatorr点亮屏幕的操作是得到相应控件后使用命令()A.wakeup

B.light

C.brightD.sleep答案:

16.Chrome的开发者工具中哪个选项可以查找到cookiesA.Elements

B.Sources

C.NetworkD.Peformance答案:

17.Scrapy中使用Xpath获得的结果调用了.extract方法,结果以()形式生成

A.列表B.元组C.字典D.集合答案:

18.以下哪个命令是创建文件夹命令()A.curl

B.tar-zxvfC.mkdirD.cp

19.可以通过()绕过网站登录。

A.sessionB.cookiesC.moonpiesD.localstorage答案:

20.Python中把列表转换为集合需要使用##函数

A.setB.listC.convertD.change答案:

二、多选题(共5道试题,共10分)21.Python中的容器有()

A.列表B.元组C.字典D.集合

ABCD

22.HTTP常用状态码表明表明服务器本身发生错误的有()A.403

B.4C.500D.503

CD

23.Python中哪种容器生成后可以修改内容

ACD

24.最常见的HTTP请求类型有()A.GET

B.POSTC.SENDD.RECEIVE

AB

25.BS4可以用来从()中提取数据

A.HTML

B.XML

C.数据库D.JSON

三、判断题(共10道试题,共20分)

26.在Linux的终端使用apt-get命令安装一系列依赖库时,其中如果存在有已经安装的库,会覆盖掉之前的库重新安装

错误

27.使用Nginx反向代理到Scrapyd以后,Scrapyd本身只需要开通内网访问即可,不许经过输入密码

正确

28.process_spider_output(response,result,output)是在下载器中间件处理完成后,马上要进入某个回调函数parse_xxx()前调用

29.Robo3T与RoboMongo是完全不一样的软件答案:

30.Python正则表达式中“.*?

”是非贪婪模式,获取最短的能满足条件的字符串。

31.Redis插入数据都是插入到列表右侧,因此读取数据也是从右侧读取答案:

32.爬虫登录需要识别验证码可以先把程序关闭,肉眼识别以后再重新运行答案:

33.在Ubuntu下若要运行Redis可以使用CMD进入解压以后的文件夹并运行命令

redis-server.exeredis.windows.conf启动Redis

34.middlewares.py是下载器中间件答案:

35.在charles中使用CTRL+F搜索,JSON里面的中文是可以直接搜索到的。

四、主观填空题(共4道试题,共8分)

36.使用了RedisSpider作为爬虫的父类以后,爬虫会直接监控##中的数据,并不读取start_urls中的数据。

Redis

37.一般通过##表达式来解析网页数据答案:

正则

38.实现异步加载需要利用##技术答案:

Ajax

39.Python中定义函数关键字为##答案:

def

五、简答题(共2道试题,共10分)

40.Python正则表达式中search和findall方法比较

search()的用法和findall()的用法一样,但是search()只会返回第1个满足要求的字符串。

一旦找到符合要求的内容,它就会停止查找。

<

br>

41.在MacOS下安装Scrapy,当pip的网络受到干扰导致安装的速度很慢时,应该如何应对?

答案:

可以使用一些代理工具来让网络变得稳定,例如ProxyChains。

六、名词解释(共4道试题,共12分)42.multiprocessing

multiprocessing本身是Python的多进程库,用来处理与多进程相关的操作

43.URI

UniformResourceIdentifier,统一资源标志符<

44.CSS

CascadingStyleSheets,层叠样式表<

45.HTML

HTML是一种结构化的标记语言,可以描述一个网页的结构信息<